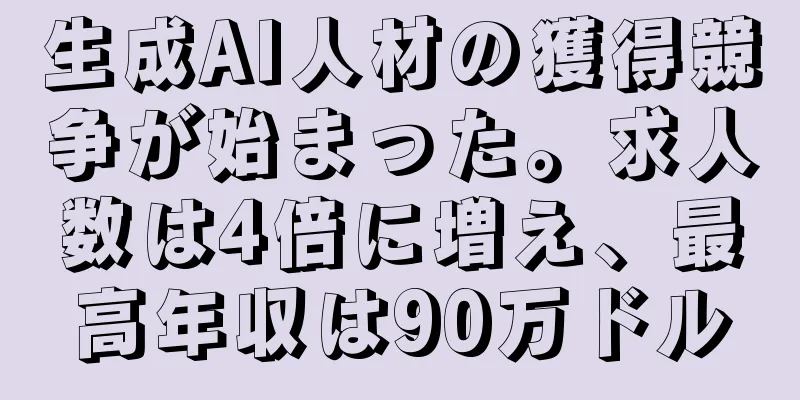

「ドメイン外」テキストは不要、Microsoft: NLP はターゲットを絞った方法で事前トレーニングする必要がある

|

バイオメディカルなどの専門分野では、NLP モデルのトレーニングには、特定のデータセットに加えて、「ドメイン外」のテキストも有用であると見なされる必要があります。しかし最近、マイクロソフトの研究者は「そうは思わない」と叫んでいます。 事前トレーニングとは何ですか? これは、人工知能に詳しくない人にとっては、魂を問う質問です。 人間である私たちは、すべてを一から学ぶ必要はありません。しかし、私たちは「古い知識を使って新しいことを学ぶ」、つまり過去に学んだ古い知識を使って新しい知識を理解し、さまざまな新しいタスクを処理することになります。 人工知能では、事前トレーニングは人間のこのプロセスを模倣することです。 事前トレーニングという用語は論文でよく見られ、これはモデルを 1 つのタスクでトレーニングして、他のタスクで使用できるパラメータを形成することを指します。 学習したタスクのモデル パラメータを使用して、新しいタスクのモデル パラメータを初期化します。このように、古い知識は、新しいモデルがゼロから始めるのではなく、古い経験から新しいタスクを正常に実行するのに役立ちます。 これまでの研究では、バイオメディカルなどの専門分野では、ドメイン固有のデータセットを使用すると、NLP モデルのトレーニングの精度が向上することが示されています。しかし、「外国語」のテキストも有用であるという一般的な認識もあります。

しかし!マイクロソフトの研究者たちはその仮定に異議を唱えた。

最近、マイクロソフトの研究者は、生物医学 NLP 用のドメイン固有言語モデルを事前トレーニングするための人工知能テクノロジを提案しました。そして、公開データセットから「包括的な」生物医学NLPベンチマークをコンパイルすることで、固有表現認識、証拠に基づく医療情報抽出、文書分類などのタスクで最先端の結果を達成したと自信を持って述べています。 彼らは、「混合ドメイン」の事前トレーニングを考えていますか?それは転移学習の別の形ではないでしょうか?ソース ドメインは一般的なテキスト (ニュースなど) であり、ターゲット ドメインは専門的なテキスト (生物医学論文など) です。 これに基づくと、特定のドメイン向けの生物医学 NLP モデルの事前トレーニングは、一般的な言語モデルの事前トレーニングよりも常に優れており、「混合ドメイン」の事前トレーニングは完璧ではないことがわかります。 ニューラル言語モデルを事前トレーニングするための 2 つのパラダイム。 「混合ドメイン」事前トレーニング(上);ドメイン内テキストのみを使用した事前トレーニング(下) 研究者たちはその自信を裏付ける証拠を持っている。 彼らは、バイオメディカル NLP アプリケーションへの影響を調べることで、事前トレーニング モデリングとタスク固有の微調整を比較しました。 最初のステップとして、彼らは生物医学言語理解および推論ベンチマーク (BLURB) と呼ばれるベンチマークを作成しました。これは、PubMed (生物医学関連のデータベース) が提供する出版物に焦点を当て、関係抽出、文の類似性、質問応答などのタスクと、はい/いいえの質問応答などの分類タスクをカバーしています。要約スコアを計算するには、BLURB のコーパスをタスク タイプ別にグループ化し、個別にスコアを付けてから、全体の平均を計算します。 評価のために、彼らは語彙を生成し、最新の PubMed 文書 (1,400 万件の要約と 32 億語、合計 21 GB) でモデルをトレーニングしました。トレーニングには、16 枚の V100 グラフィック カードを搭載した 1 台の Nvidia DGX-2 マシンで約 5 日間かかりました。このモデルのステップ長とバッチ サイズは 62,500 で、これは以前の生物医学事前トレーニング実験で使用された計算量に匹敵します。 研究者らは、自分たちのモデルである PubMedBERT が Google の BERT をベースに構築されているという点も確信していると述べた。 あのすごいBERT? 2018年にGoogleが提案したNLPモデルは、近年のNLP分野において最も画期的な技術となっています。

しかし興味深いことに、事前トレーニング テキスト (168 億語) に PubMed の全文を追加すると、事前トレーニング時間が長くなるまでパフォーマンスがわずかに低下します。しかし研究者たちは、これは部分的にはデータ内のノイズによるものだと考えている。 「本論文では、ニューラル言語事前トレーニング モデル (つまり、「混合ドメイン」事前トレーニング) における一般的な仮定に異議を唱え、特定のドメインでゼロから事前トレーニングを行うことで、「混合ドメイン」事前トレーニングよりも大幅に優れたパフォーマンスが得られることを示します。 「私たちはバイオメディカルNLPアプリケーションにおいて、新たな最先端の成果を達成しました」と研究者らは記している。「今後は、分野固有の事前トレーニング戦略をさらに探求し、BLURBベンチマークを臨床分野やその他の価値の高い分野に拡張していきます。」 バイオメディカル NLP の研究を促進するために、研究者は BLURB ベンチマークを特集したリーダーボードを作成しました。彼らはまた、事前にトレーニングされたタスク固有のモデルをオープンソースとしてリリースしました。 この研究はプレプリントウェブサイトarxivに掲載されました。 |

<<: ファーウェイはAscend AIフルスタックソフトウェアプラットフォームをリリースし、AI開発がコンピューティングパワーとアプリケーションのギャップを埋めるのを支援します。

推薦する

人工知能が再び警告を発する!研究者は懸念している:将来、研究者が全てを支配することになる

人間と超人工知能の関係の発展は、長年にわたり話題となっている。少し前に、「人工知能研究ジャーナル」で...

将来スマートフォンは消滅するのでしょうか? Huaweiがそれに代わるスマートフォンを発売します!

スマートフォンの登場と普及は人々の生活に大きな楽しさと便利さをもたらしました。携帯電話がもっとスマー...

アルゴリズムに関する8冊の良書を読めば、AIを本当に理解できる

[[241723]]新しい技術を学ぶとき、多くの人は公式ドキュメントを読み、ビデオチュートリアルやデ...

今後10年間で、AIは「スモールデータ」時代の到来を告げるでしょうか?

AI 研究に携わる人なら誰でも、データが AI の開発において重要な役割を果たすことをよく知ってい...

新浪微博廖博:WAICリアルタイムストリームコンピューティングプラットフォームの成長と発展

[51CTO.com からのオリジナル記事] 7 年間の努力と見事な変貌。 2012年以降、6年連続...

GitHub上の8,800のオープンソース機械学習プロジェクトを比較し、上位30を選出しました。

[[218787]]編集者: Ye Yi、Shan Liu、Aileen 2017 年は機械学習の...

歯を磨くのが面倒ですか?マイクロロボットは自動的にそれを手伝ってくれ、いつでも歯ブラシとデンタルフロスを交換することもできます。

この記事はAI新メディアQuantum Bit(公開アカウントID:QbitAI)より許可を得て転載...

Langchain、ChromaDB、GPT 3.5 に基づく検索強化型生成

翻訳者|朱 仙中レビュー | Chonglou概要:このブログでは、検索拡張生成と呼ばれるプロンプト...

Go 向けに設計された機械学習ライブラリ Gorgonia: TensorFlow や Theano のライバル

[[184558]] Gorgonia は、Go での機械学習を容易にし、多次元配列を含む数式の記述...

Google の 10 秒動画生成モデルが世界記録を更新しました。 LLMは拡散モデルを終わらせ、その影響は第2世代のトップを圧倒する

AI ビデオ生成は、2024 年には次の最先端分野になる可能性があります。過去数ヶ月を振り返ると、R...